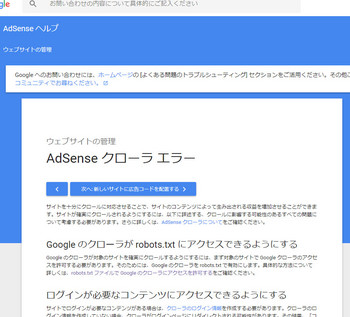

「Robots: robots.txt にアクセスできない」とアドセンス画面に表示されたり

Search Console(サーチコンソール)のメッセージに

「サイトの robots.txt ファイルにアクセスできなかったため、

サイトをクロールすることができませんでした。」と

エラーになってしまう時の一つの解決法を紹介したいと思います。

今回はワードプレスでAdSenseブログを運営している人向けです。

僕が実行した解決策は

robots.txt ファイルを作成して

FTPでドメイン直下に robots.txt ファイルを置く。

ということをしました。

クローラーエラーだと広告が表示されない!?

まず環境を説明しますね。

サーバーはロリポップ

独自ドメインをワードプレスで運営

最近SSL化した。

このような状況で

robots.txt にアクセスできない

というエラーメッセージがでました。

すると広告も表示されなくなり

アクセスもどんどん下がっていったので

あわてて調べて何とか解決した感じです。

なので実際のところよくわかっていません^^;

備忘録的にまとめたので一応自己責任でお願いします。

【問題の流れ】

AdSenseが何か表示されていない。

収益がどんどん下がっている・・と思ったらクローラーエラーが。。。。

【管理画面のメッセージからの流れ↓】

広告クローラのエラーが生じており、収益の損失が発生する可能性があります。

↓

「操作」

↓

クローラが [ブロックされた URL] 列に記載されたページにアクセスできず、

コンテンツを分析して広告を表示することができません。

各ドメインの横のプラス アイコンをクリックして、

ブロックされている URL の詳しいリストをご覧ください。

クローラがコンテンツにアクセスできないと、

広告が表示されないため、広告の収益と掲載率は低下します。

[エラー] 列のリンクをクリックしてエラーを修正する方法をご確認ください

↓

ブロックされたURL

https://○○

ブロックURLは100個以上

エラー

Robots: robots.txt にアクセスできない

↓

【解決策】

クローラのページへのアクセスを許可するように robots.txt ファイルを更新するには、

robots.txt ファイルから次の 2 行のテキストを削除します。

User-agent: Mediapartners-Google

Disallow: /

とまぁ、

Googleさんの提示する解決策は

何を言っているのか全然わからないのですが

お金が関わると必死になるものですね・・・

最初はサイトのURLを更新サービスに送信したり

サーチコンソールにサイトを登録したりみましたが

サーチコンソールでも

「サイトの robots.txt ファイルにアクセスできなかったため、

サイトをクロールすることができませんでした。」

と表示されたので、結局のところ

Google のクローラが robots.txt にアクセスできるようにする

方法を探し出さなければなりませんでした。

仮想robots.txtが自動生成されているらしい?

何でもワードプレスのインストール時に

robots.txtは仮想robots.txtとして自動生成されているみたいです。

robots.txtはクローラーに対して制限をかけたりする役割で

さっきの

User-agent: Mediapartners-Google

Disallow: /

というのは

Googleのクローラーを巡回させないという指示なんです。

そのコードを消して。ということなんですね。

でも仮想なのでtxtファイルがないのです。

robots.txtの確認の仕方は

ブラウザからhttps://ドメイン名/robots.txt

で確認できるのですが

ワードプレスのパーマメント設定がデフォルト状態だと

404エラーになってしまうので

パーマメントの設定を一番上のデフォルト状態から下のどれか、

カスタムにでもすれば解消します。

ちなみに僕はそれでも確認できませんでした。

どうも仮想robots.txtがないみたいです。

もうね、全然意味がわからない(泣)

robots.txt の作成と設置

無い物は作れ!

ということで仮想robots.txtがないのなら

robots.txtファイルをつくりましょうか。

ということになりまして

調べてみるとテキストファイル(メモ帳)に

robots.txtという名前でドメインに置けばいいみたいです。

例え仮想robots.txt があっても

実際のrobots.txtファイルが優先されるみたいなので

じゃあやるかと。

User-agent:

Disallow: /ワードプレスのファイル

と一部クロールさせない指示を入れてみました。

一旦解消されたんですが1日後再びエラーになったので

全部許可するという意味の

User-agent: *

Allow: /

にするかと迷いましたが

空のファイルでもいいという記事を見かけましたので

空のrobots.txtファイルを置きました。

メモ帳開いて保存時に

ファイル名robots.txtにするだけです。

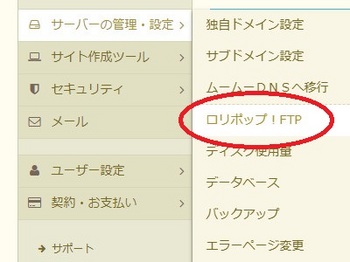

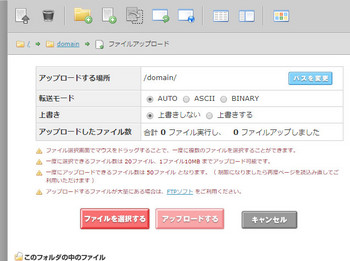

【ロリポップでrobots.txtをドメインに置く流れ】

ロリポップにログインしてロリポップ!FTPへ

↓

該当するドメイン直下へアクセスする

↓

メモ帳で作成したrobots.txtをアップロードする

↓

robots.txtが設置されました。

1日後AdSense画面を確認してみるとエラーが解消されてました。

サーチコンソールの方も

”Google が Search Console で

お客様のウェブサイトの Google 検索でのインプレッション数の収集を

開始したことを Google のシステムが確認しました。”

という通知がきてエラーが解消されたみたいです。多分。

如何でしたでしょうか?

・ロリポップで

・SSL化してから

・AdSense画面で

・サーチコンソールで

クローラーエラーの表示が出たら参考にしてみて下さい。

備考

今度は新たにサーチコンソールで

「インデックス カバレッジ」の問題が新たに 検出されました

というエラーがでました。うんざり。

これの対処法はプラグインのXML Sitemap の設定の

HTML形式でのサイトマップを含めるの

チェックを外すことらしいのですが・・・どうなることやら^^;

コメント 0

コメントを書く